Yapay Zeka için Nvidia H100 NVL

Üst Düzey Yapay Zeka Çıkarımı için NVIDIA H100 NVL Piyasaya Sürüldü

Yapay Zeka için Nvidia H100 NVL

NVIDIA H100 HVL daha önce gördüğümüz bir şeye benzeyebilir ancak arada büyük bir fark var. NVIDIA’ya sorduk ve şirket mantıksal olarak bunun işletim sistemi için iki GPU olduğunu ancak NVLink’in 188 GB belleğin tamamının sistem tarafından kullanılmasına izin vereceğini söyledi.

Üst Düzey Yapay Zeka Çıkarımı için NVIDIA H100 NVL Piyasaya Sürüldü

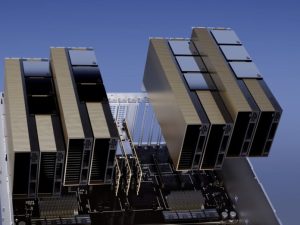

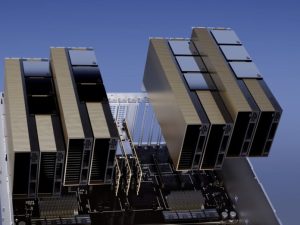

Yeni NVIDIA H100 NVL, iki NVIDIA H100 PCIe’yi NVLink ile bir araya getiriyor ve bir yenilik getiriyor. Yeni NVL sürümünde GPU başına 94 GB, toplam 188 GB HBM3 bellek bulunuyor. Bu muhtemelen altıncı 16GB’lık yığının etkinleştirildiği, ancak 96GB’lık aktif alanın 94GB’ı için yalnızca 14GB’ın mevcut olduğu anlamına geliyor.

Gerçekten ilginç olan da TDP’dir. Bunlar 350W ila 400W TDP PCIe kartlarıdır. Genel olarak, çoğu sunucu PCIe form faktörlerinde 400W’ı işleyemediğinden, PCIe kartlarındaki diğer satıcıların çoğunda gördüğümüz en üst seviye 300W’tır. Bu, üst düzey OAM/SXM form faktörleri için büyük bir etkendir.

| H100SXM | H100 PCIe | H100NVL | |

|---|---|---|---|

| FP64 | 34 teraFLOPS | 26 teraFLOPS | 68 teraFLOP |

| FP64 Tensör Çekirdeği | 67 teraFLOPS | 51 teraFLOPS | 134 teraFLOP |

| FP32 | 67 teraFLOPS | 51 teraFLOPS | 134 teraFLOP |

| TF32 Tensör Çekirdeği | 989 teraFLOPS 1 | 756teraFLOPS 1 | 1.979 teraFLOP 1 |

| BFLOAT16 Tensör Çekirdeği | 1.979 teraFLOPS 1 | 1.513 teraFLOPS 1 | 3.958 teraFLOP 1 |

| FP16 Tensör Çekirdeği | 1.979 teraFLOPS 1 | 1.513 teraFLOPS 1 | 3.958 teraFLOP 1 |

| FP8 Tensör Çekirdeği | 3.958 teraFLOPS 1 | 3.026 teraFLOPS 1 | 7.916 teraFLOP 1 |

| INT8 Tensör Çekirdeği | 3.958 ÜST 1 | 3.026 ÜST 1 | 7.916 ÜST 1 |

| GPU belleği | 80 GB | 80 GB | 188GB |

| GPU bellek bant genişliği | 3,35 TB/sn | 2 TB/sn | 7,8 TB/sn |

| Kod çözücüler | 7 NVDEC 7 JPEG |

7 NVDEC 7 JPEG |

14 NVDEC 14 JPEG |

| Maksimum termal tasarım gücü (TDP) | 700W’a kadar (yapılandırılabilir) | 300-350W (yapılandırılabilir) | 2x 350-400W (yapılandırılabilir) |

| Çoklu Örnek GPU’lar | Her biri 10 GB’ta 7 MIGS’ye kadar | Her biri 12 GB’ta 14 MIGS’ye kadar | |

| Form faktörü | SXM | PCIe Çift yuvalı hava soğutmalı |

2x PCIe Çift yuvalı hava soğutmalı |

| Ara bağlantı | NVLink: 900 GB/sn PCIe Gen5: 128 GB/sn |

NVLink: 600 GB/sn PCIe Gen5: 128 GB/sn |

NVLink: 600 GB/sn PCIe Gen5: 128 GB/sn |

Spesifikasyonlara dayanarak, NVIDIA H100 NVL spesifikasyonlarının 400W için olduğunu varsayarsak, PCIe versiyonlarının H100 SXM5 versiyonlarından çok daha üstün olduğu ancak üst seviye 900GB/s NVLINK arayüzleri olmadığı görülüyor. Hesaplama özellikleri H100 SXM’nin 2 katıdır, ancak NVL sürümü daha fazla belleğe, daha yüksek bellek bant genişliğine sahiptir ve performans için benzer gücü kullanır.

Son sözler

Bizim düşüncemiz, NVL’nin değerinin düşürülmesi gerektiği veya H100 SXM5’in yakın zamanda eşleşmesi için spesifikasyon artışına ihtiyaç duyacağı yönünde. Bu çok garip bir konumlandırma. Yine de NVIDIA, ChatGPT için artık DGX A100’leri kullanan OpenAI’nin, çıkarımını yapmak için 10x’e kadar DGX A100 sistemini dört set NVIDIA H100 NVL çiftiyle değiştirebileceğini söylüyor. Zamanla bunların değerinin düşürülüp düşürülmeyeceğini veya H100 SXM5’in güncellenip güncellenmeyeceğini görmek ilginç olacak.